基本信息

标准号: GB/T 42382.1-2023

中文名称:信息技术 神经网络表示与模型压缩 第1部分:卷积神经网络

标准类别:国家标准(GB)

英文名称:Information technology—Neural network representation and model compression—Part 1:Convolutional neural network

标准状态:现行

发布日期:2023-03-17

实施日期:2023-10-01

出版语种:简体中文

下载格式:.pdf .zip

下载大小:37822088

标准分类号

标准ICS号:信息技术、办公机械设备>>35.040字符集和信息编码

中标分类号:电子元器件与信息技术>>信息处理技术>>L71编码、字符集、字符识别

关联标准

出版信息

出版社:中国标准出版社

页数:256页【胶订-大印张】

标准价格:187.0

相关单位信息

起草人:田永鸿、杨帆、纪荣嵘、单弈、陈光耀、燕肇一、郑侠武、浦世亮、谭文明、李哲暘、彭博、钟刚、赵恒锐、段文鸿、胡浩基、李翔、骆阳、王炜、许奕星、李慧霞、林绍辉、王培松、赵依、胡晓光、郑辉煌、蒋佳军、马金成、程健、江帆、朱文武、汪小娟、高文、黄铁军、赵海英、马珊

起草单位:北京大学、鹏城实验室、深圳市海思半导体有限公司、赛灵思电子科技(北京)有限公司、杭州海康威视数字技术股份有限公司、北京百度网讯科技有限公司、深圳市腾讯计算机系统有限公司、华为技术有限公司、厦门大学、中国电子技术标准化研究院、中国科学院自动化研究所等

归口单位:全国信息技术标准化技术委员会(SAC/TC 28)

提出单位:全国信息技术标准化技术委员会(SAC/TC 28)

发布部门:国家市场监督管理总局 国家标准化管理委员会

标准简介

标准图片预览

标准内容

CCS L 71

中华人民共和国国家标准

GB/T42382.1—2023

信息技术

神经网络表示与模型压缩

第1部分:卷积神经网络

Information technologyNeural network representation and model compression-Part1:Convolutional neural network2023-03-17发布

国家市场监督管理总局

国家标准化管理委员会

2023-10-01实施

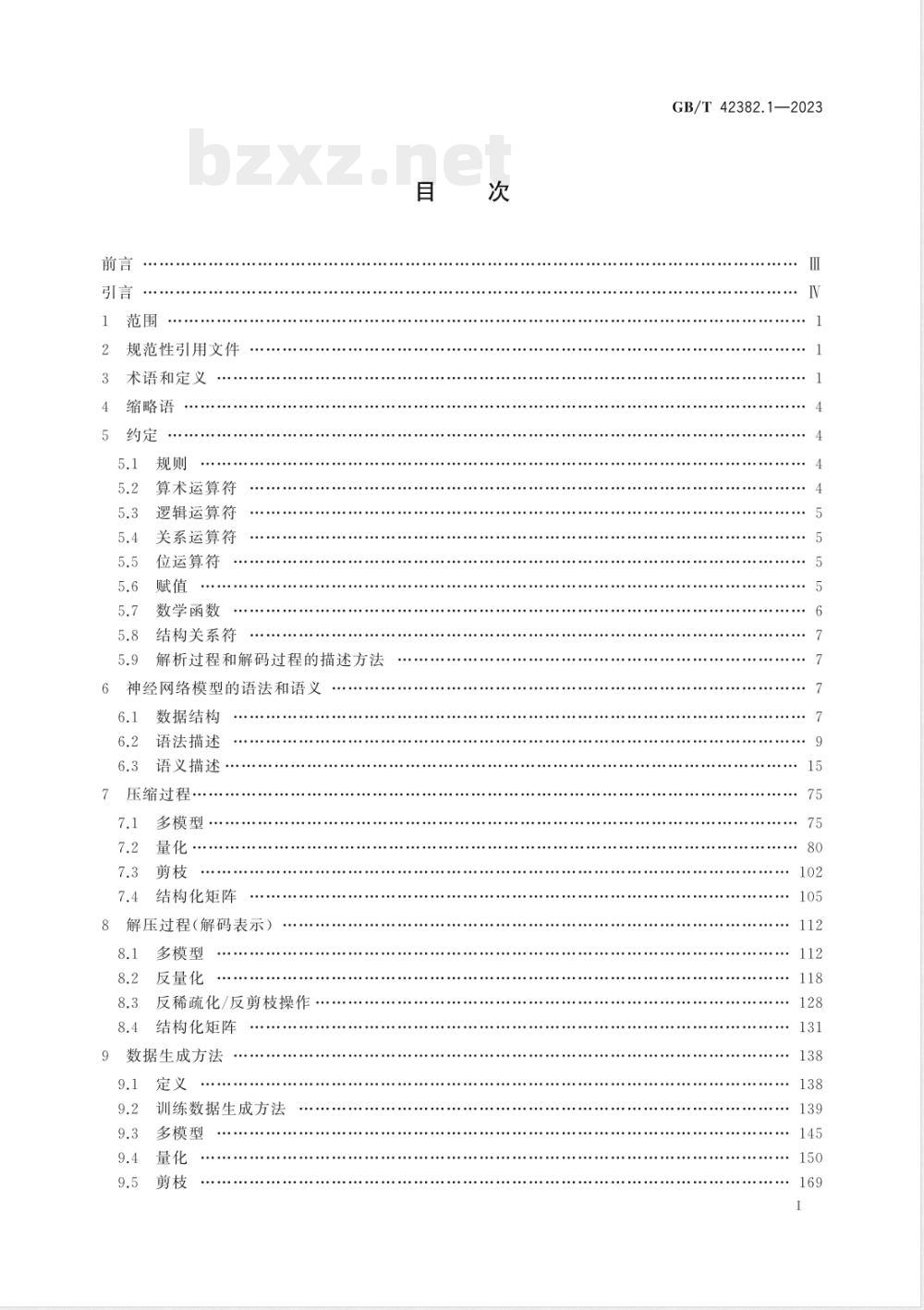

规范性引用文件

术语和定义

缩略语

算术运算符

逻辑运算符

关系运算符

位运算符

数学函数

结构关系符

解析过程和解码过程的描述方法神经网络模型的语法和语义

数据结构

语法描述

语义描述

7压缩过程·

多模型·

结构化矩阵

8解压过程(解码表示)

多模型

反量化

反稀疏化/反剪枝操作

结构化矩阵

数据生成方法

训练数据生成方法

多模型

GB/T42382.1—2023

GB/T42382.1—2023

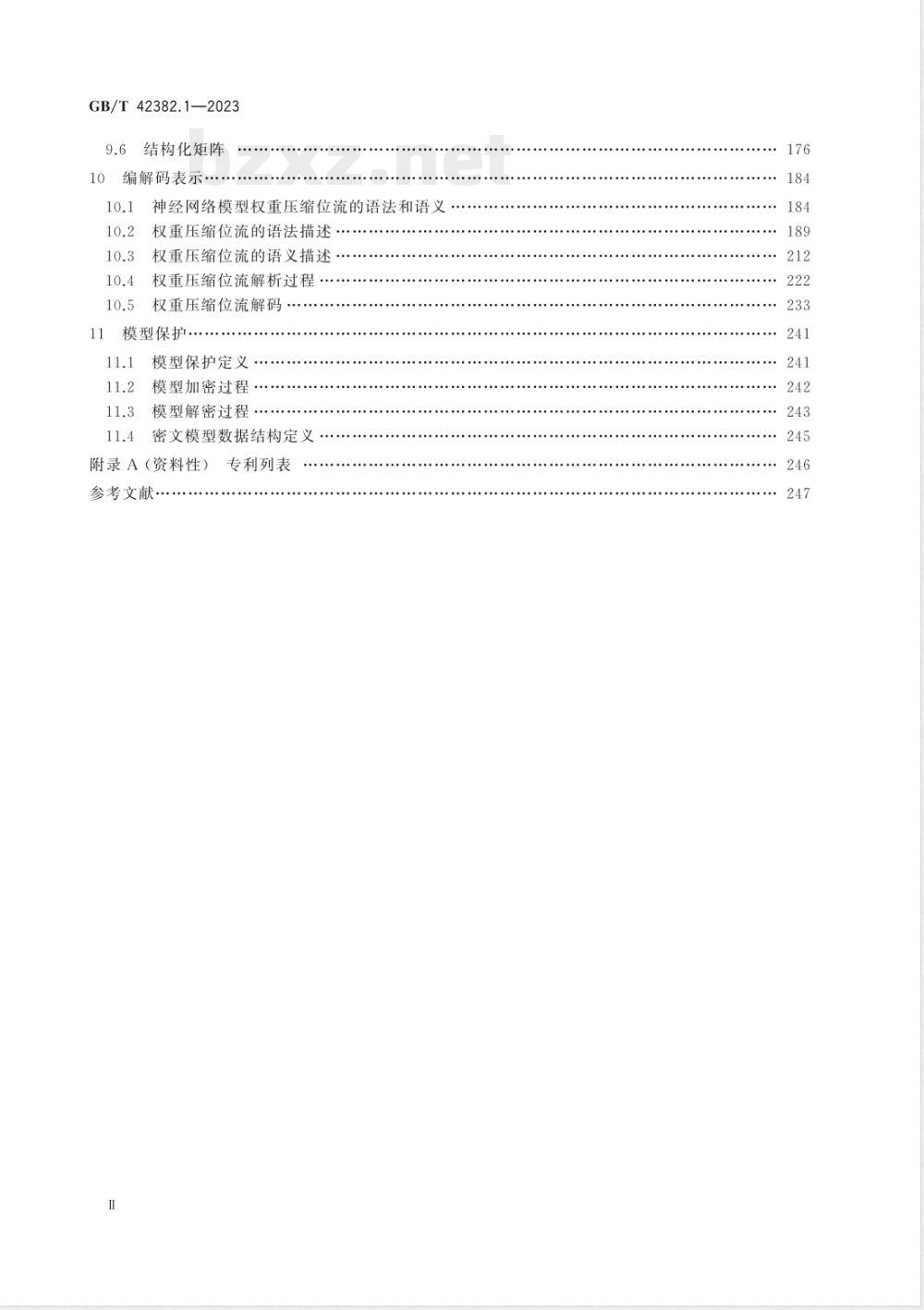

结构化矩阵

编解码表示

神经网络模型权重压缩位流的语法和语义权重压缩位流的语法描述

权重压缩位流的语义描述

权重压缩位流解析过程

权重压缩位流解码

模型保护

模型保护定义

模型加密过程·

模型解密过程

密文模型数据结构定义

专利列表

附录A(资料性)

参考文献

GB/T 42382.1—2023

本文件按照GB/T1.1一2020《标准化工作导则第1部分:标准化文件的结构和起草规则》的规定起草。

本文件是GB/T42382《信息技术

布了以下部分:

第1部分:卷积神经网络

神经网络表示与模型压缩》的第1部分。GB/T42382已经发本文件由全国信息技术标准化技术委员会(SAC/TC28)提出并归口。本文件起草单位:北京大学、鹏城实验室、深圳市海思半导体有限公司、赛灵思电子科技(北京)有限公司、杭州海康威视数字技术股份有限公司、北京百度网讯科技有限公司、深圳市腾讯计算机系统有限公司、华为技术有限公司、厦门大学、中国电子技术标准化研究院、中国科学院自动化研究所、浙江大学、中国科学技术大学、上海交通大学、清华大学、中关村视听产业技术创新联盟。本文件主要起草人:田永鸿、杨帆、纪荣嵘、单奔、陈光耀、燕肇一、郑侠武、浦世亮、谭文明、李哲陽、彭博、钟刚、赵恒锐、段文鸿、胡浩基、李翔、骆阳、王炜、许奕星、李慧霞、林绍辉、王培松、赵依、胡晓光、郑辉煌、蒋佳军、马金成、程健、江帆、朱文武、汪小娟、高文、黄铁军、赵海英、马珊珊。GB/T 42382.1—2023

神经网络的表示和模型压缩是人工智能技术体系的重要组成部分,是国民经济各行业应用人工智能的前提。然而,多源算法平台不能协同工作,模型不可以相互转换,制约了人工智能技术的传播和应用。为了保证人工智能技术的跨平台可操作性,提升模型复用效果,本标准将对神经网络的表示和模型压缩进行规范,带动人工智能产业的健康、快速发展。GB/T42382旨在确立适用于卷积神经网络、大规模预训练网络及图神经网络的神经网络表示与模型压缩的规范,拟由三个部分组成:第1部分:卷积神经网络。目的在于确立适用于卷积神经网络的表示与模型压缩标准,第2部分:大规模预训练模型。目的在于确立适用于大规模预训练网络的模型表示、模型压缩及模型传输标准。

一第3部分:图神经网络。目的在于确立图数据和图神经网络表示,确定图神经网络模型的编码格式标准,

本文件的发布机构提请注意,声明符合本文件时,可能涉及到6、7、8、9、10、11与《神经网络表示标准框架结构》(专利号:201810575097.7);7.1.4、8.1.3、9.3.2与《基于神经网络差分的量化方法及系统》(专利号:201910478617.7);7.2、8.2、9.4与《一种基于参数范数的神经网络量化方法》(专利号:201810387893.8);7.4.2、8.4.2、9.6.2与《一种神经网络计算方法和装置》(专利号:PCT/CN2018/101598);7.1.3、8.1.2、9.3.1与《一种神经网络模型、数据处理方法及处理装置》(专利号:PCT/CN2019/085885)、《一种神经网络模型、数据处理方法及处理装置》(专利号:201810464380.2);7.2.3.3、7.2.4.3、8.2.3.3、8.2.4.3、9.4.1.1、9.4.2.1与《Neural NetworkQuantization Method usingMultipleRefined Quan-tizedKernelsforConstrainedHardwareDeployment》(专利号:PCT/EP2o19/o53161);9.2.2与《图像生成方法、神经网络的压缩方法及相关装置、设备》(专利号:201910254752.3);7.2.4.1、8.2.4.1、9.4.2.2与《模型训练方法、装置、存储介质和程序产品》(专利号:PCT/CN2019/129265);7.2、8.2与《神经网络模型和训练方法和装置》(专利号:CN202010144315.9)、《神经网络模型的量化方法和装置》(专利号:CN202010143782.X)、《神经网络模型的量化方法和装置》(专利号:CN202010144339.4)、《神经网络模型压缩方法以及装置》(专利号:CN201610943049.X);6.2、6.3与《DEEPLEARNINGPROCESSINGAPPARATUSANDMETHOD,DEVICEANDSTORAGEMEDIUM》(专利号:US17/017,600);7.4、8.4与《NEURALNETWORKDATAPROCESSINGAPPARATUS,METHODANDELECTRONICDEVICE》(专利号:US16/893,044);7.2、8.2、9.4与《基于多比特神经网络非线性量化的深度神经网络压缩方法》(专利号:201910722230.1);7.3、8.3、9.5与《一种基于结构化剪枝的高效图像分类方法》(专利号:201910701012.X);7.3、8.3、9.5与《一种基于增量正则化的神经网络结构化稀疏方法》(专利号:201910448309.X);11与《一种模型数据的处理方法、装置及设备》(专利号:201911230340.2);7.2.3.4、7.2.4.4、7.2.4.5与《一种应用有界线性整流单元的全整数神经网络系统》(专利号:2019104537988);7.4、8.4、9.6与《基于张量分解的深度卷积神经网络的加速与压缩方法》(专利号:201610387878.4)相关专利的使用。本文件的发布机构对于该专利的真实性、有效性和范围无任何立场。该专利持有人已向本文件的发布机构承诺,他愿意同任何申请人在合理且无歧视的条款和条件下,就专利授权许可进行谈判。该专利持有人的声明已在本文件的发布机构备案,相关信息可以通过以下联系方式获得:

专利持有人:北京大学、华为技术有限公司、北京百度网讯科技有限公司、厦门大学、浙江大学、赵恒锐、中科院自动化研究所

GB/T42382.1—2023

地址:北京市海淀区颐和园路5号理科2号楼2604室邮编:100871;北京市上地信息路3号华为大厦邮编:100085;北京市海淀区上地十街10号百度大厦邮编:100085;福建省厦门市思明区厦门大学信息学院邮编:361005;浙江省杭州市西湖区浙大路38号浙江大学玉泉校区邮编:310000;安徽省合肥市蜀山区中国科学技术大学西区邮编:230027;北京市海淀区中关村东路95号邮编:100190联系人:黄铁军

通讯地址:北京大学理科2号楼2641室电子邮件:tjhuang@pku.edu.cn电话:+8610-62756172

请注意除上述专利外,本文件的某些内容仍可能涉及专利。本文件的发布机构不承担识别专利的责任。

1范围

信息技术神经网络表示与模型压缩第1部分:卷积神经网络

本文件规定了卷积神经网络离线模型的表示与压缩过程GB/T 42382.1—2023

本文件适用于各种卷积神经网络模型的研制、开发、测试评估过程,以及在端云领域的高效应用。注:对于本文件规定的表示与模型压缩方法不要求机器学习框架原生支持,可以通过转换、工具包等形式支持2规范性引用文件

下列文件中的内容通过文中的规范性引用而构成本文件必不可少的条款。其中,注日期的引用文件,仅该日期对应的版本适用于本文件;不注日期的引用文件,其最新版本(包括所有的修改单)适用于本文件。

GB/T5271.34—2006信息技术词汇第34部分:人工智能神经网络

3术语和定义

下列术语和定义适用于本文件。3.1

编解码表示

codecrepresentation

使用压缩技术减少模型的规模

注:具体定义参考编解码表示,见第10章。3.2

层layer

神经网络中的分级结构

注:每个网络层包含多个个算子,例如输人层,卷积层,全连接层。3.3

参考随机向量referencerandomvector整个网络共存的基础符号向量。3.4

多重INT4量化multipleINT4quantization一种量化的方式,将一个张量量化为多个INT4张量的组合的量化方式。3.5

封装表示

encapsulation representation支出安全信息和身份验证等接口。注:具体定义参考模型保护,见第11章。3.6

分块结构化矩阵

blockstructuredmatrix

可以分为多个块,且每个分块均按照某种规律排列的矩阵。1

GB/T42382.1—2023

分块循环矩阵

Eblock circulantmatri

每个分块为循环矩阵的矩阵。

shared weight

共享权重

共享权重值shared weightvalue共享权重张量sharedweighttensor一个神经网络处理多个不同任务,多个任务共享的权重部分。3.9

共享偏置

sharedbias

量sharedbiasvector

共享偏置向量

用一个神经网络处理多个不同任务,多个任务共享的偏置部分。3.10

卷积神经网络

convolutionalneuralnetwork

种前馈神经网络,在其至少一层中使用卷积,注:是人工智能应用中代表的深度学习算法,定义参见ISO/IECDIS22989:2022。3.11

紧表示

compactrepresentation

输出通过多种神经网络紧凑表示算法压缩后的序列化格式示例:结构化矩阵、多模型间权重共享、稀疏编码的稀疏矩阵、权重量化的量化表、低秩分解的分解矩阵和二值神经网络的位表示

注:具体定义参考压缩过程、解压过程、数据生成方法,见第7章~第9章,3.12

基础符号向量basicsymbolvector包括整个网络共存的基础符号向量,以及每层对应的基础符号向量,其中,每层对应的基础符号向量是以某约定规则从网络的基础符号向量中获得。3.13

校正输入向量

correctinputvector

网络层的输人向量中的元素与扰动向量中对应位置的元素相乘,所得到的向量。3.14

structured matrix

结构化矩阵

一类特殊的矩阵,可以通过使用较少的数据以及一定的排列规律,构成完整的矩阵。3.15

卷积核粒度量化

convolutionkernel granularityquantization一种量化的方式,对于卷积层权重,以输出channel切分,逐个3D卷积核进行的量化方式,3.16

可互操作表示

interoperablerepresentation

对神经网络的语法定义、支持的运算操作定义和权重格式(整型、浮点型和定点型)的定义。注:具体定义参考神经网络模型的语法和语义,见第6章。3.17

量化尺度因子

quantitative scale factor

原始张量与量化后的张量的缩放比例。2

模型压缩

modelcompression

减小神经网络模型规模,提高神经网络模型运行和传输效率的方法。模型model

对应完成单个或多个任务的神经网络。偏置biasoffset

偏置向量biasvector;offsetvector基于参考值的系统性偏差

注:具体定义参见ISO/IEC2382:2015。3.21

权重weight

权重张量

weight tensor

连接权重

connection weight;connection strength;synaptic weight一个系数,在它与其他输入值结合前,乘以人工神经元的输人值。注:具体定义参见GB/T5271.34—2006。3.22

权重聚合维度

weight aggregation dimension共享权重张量和特有权重向量进行拼接的维度3.23

任务task

用神经网络实现某种功能。

示例:如图像超级分辨率,图像降噪3.24免费标准bzxz.net

扰动向量

disturbancevector

扰动符号向量

将随机向量扩展,使其维数为网络层输入向量的维数,所得到的符号向量,3.25

神经网络表示neuralnetworkrepresentation表示神经网络的基本语法、语义、运算、超参数、码流定义方法。3.26

随机向量

randomvector

随机符号向量

单个网络层对应的基础符号向量。3.27

特有权重

uniqueweight

特有权重值uniqueweightvalue

特有权重张量uniqueweighttensor用一个神经网络处理多个不同任务,对任一任务而言,其不共享的权重部分。3.28

特有权重列表

unique weight list

GB/T42382.1—2023

用一个神经网络处理多个不同任务,除共享权重值以外的部分,也是多个任务不共享的权重部分的组合。3

小提示:此标准内容仅展示完整标准里的部分截取内容,若需要完整标准请到上方自行免费下载完整标准文档。